El gobierno del Reino Unido está trabajando en un proyecto controvertido que ha generado alarmas entre defensores de los derechos civiles y expertos en ética tecnológica: una herramienta basada en inteligencia artificial diseñada para predecir quiénes son más propensos a cometer homicidios. Según un informe publicado por The Guardian el 8 de abril de 2025, el Ministerio de Justicia británico (MoJ, por sus siglas en inglés) lleva dos años desarrollando este programa, originalmente denominado «Homicide Prediction Project» (Proyecto de Predicción de Homicidios), aunque ahora se le conoce como «Sharing Data to Improve Risk Assessment» (Compartir Datos para Mejorar la Evaluación de Riesgos). El objetivo, según el gobierno, es aumentar la seguridad pública mediante la identificación de individuos en riesgo de cometer crímenes violentos graves, incluido el asesinato. Sin embargo, críticos como la organización de derechos civiles Statewatch han calificado el proyecto de «escalofriante y distópico», alertando sobre sus implicaciones éticas, sociales y legales.

El programa utiliza algoritmos que analizan grandes cantidades de datos personales recopilados de bases de datos policiales y judiciales. Según documentos obtenidos por Statewatch, el sistema trabaja con registros de entre 100,000 y 500,000 personas, incluyendo no solo a delincuentes convictos, sino también a víctimas, testigos de crímenes, personas desaparecidas y aquellas en situaciones de vulnerabilidad. Los datos incluyen información básica como nombre, género, fecha de nacimiento y etnia, así como un número único del sistema nacional de policía. Pero lo que ha generado mayor preocupación es el uso de «marcadores de salud» considerados de «alto poder predictivo», que abarcan aspectos como problemas de salud mental, adicciones, conductas autolesivas, pensamientos suicidas, discapacidades y otras vulnerabilidades.

El proyecto se basa en herramientas de evaluación de riesgos ya existentes, como el Offender Assessment System (OASys), utilizado para predecir la reincidencia de delincuentes antes de su liberación. Sin embargo, este nuevo sistema amplía significativamente el alcance, al incluir a personas sin antecedentes penales y utilizar datos sensibles que, según los críticos, podrían perpetuar sesgos y violar derechos fundamentales.

La revelación del proyecto ha desatado un intenso debate. Organizaciones como Amnesty International y Statewatch han expresado su rechazo, argumentando que el sistema codifica prejuicios contra comunidades racializadas y de bajos ingresos. «Construir herramientas automatizadas para perfilar a personas como criminales violentos es profundamente errado», afirmó un portavoz de Statewatch, citado por The Guardian. Además, se ha señalado que el uso de datos sensibles, como los relacionados con la salud mental, es «altamente intrusivo y alarmante».

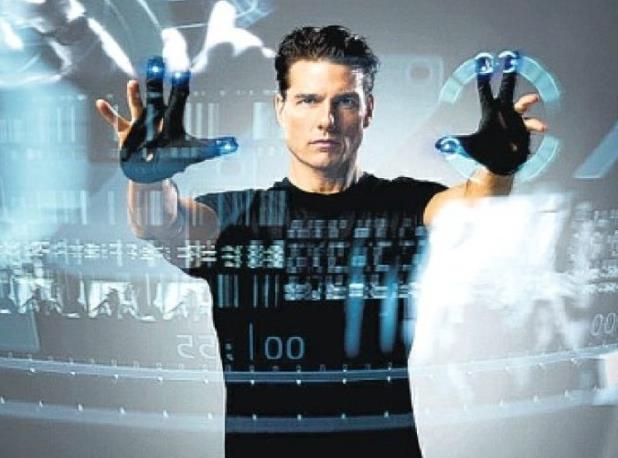

Expertos en inteligencia artificial, como Alex Hern de The Economist, han planteado preguntas sobre la viabilidad y la ética del sistema. Hern sugiere que las críticas deberían aclarar si el problema radica en que «no funcionará» o en que «funcionará, pero es moralmente inaceptable». Por su parte, France24 comparó el proyecto con la trama de la película de ciencia ficción Minority Report (2002), donde se arresta a personas antes de que cometan crímenes basándose en predicciones. Esta analogía resuena en las redes sociales, donde usuarios han expresado su inquietud sobre un posible «deslizamiento hacia un estado de vigilancia totalitaria».

Otros medios, como The Register y Euronews, han informado que el Ministerio de Justicia aún no ha implementado la herramienta, pero está en una fase de investigación para determinar su viabilidad. Sin embargo, la falta de transparencia durante los dos años de desarrollo ha alimentado las críticas. «¿Por qué mantener un proyecto de esta magnitud en secreto?», cuestionó un artículo en Decrypt, que también destacó el riesgo de que el sistema refuerce desigualdades sociales al basarse en datos históricos que reflejan sesgos estructurales.

La idea de predecir comportamientos criminales mediante algoritmos suena a una solución futurista para prevenir tragedias, pero encierra un peligro inmenso que no puede ignorarse. Este proyecto evoca no solo Minority Report, sino también otras obras distópicas como 1984 de George Orwell, donde el control estatal sobre los ciudadanos se extiende hasta sus pensamientos y potenciales acciones. La premisa de identificar «futuros asesinos» antes de que actúen plantea preguntas inquietantes: ¿es posible predecir con precisión algo tan complejo como un homicidio? Y, más importante aún, ¿es ético castigar o vigilar a alguien por lo que un algoritmo cree que podría hacer?

El uso de datos sensibles, especialmente los relacionados con la salud mental, es particularmente alarmante. Las personas que han buscado ayuda por problemas psicológicos, que han sido víctimas de abuso o que enfrentan discapacidades podrían ser injustamente señaladas como amenazas, lo que no solo estigmatiza a los más vulnerables, sino que podría disuadirlos de buscar apoyo. Además, los algoritmos no son neutrales: están entrenados con datos históricos que a menudo reflejan prejuicios raciales, económicos y sociales. Como resultado, comunidades marginadas podrían ser desproporcionadamente perfiladas, perpetuando un ciclo de discriminación disfrazado de «seguridad pública».

Otro aspecto preocupante es la erosión de la privacidad. Recolectar y analizar datos de cientos de miles de personas, muchas de las cuales no han cometido ningún delito, representa una intrusión masiva en la vida personal. ¿Dónde está el límite? Si el gobierno puede predecir asesinatos, ¿qué le impide extender esta lógica a otros comportamientos considerados «peligrosos»? El riesgo de un estado que actúa preventivamente, basándose en suposiciones algorítmicas, abre la puerta a un sistema donde la presunción de inocencia desaparece.

Por último, la opacidad del proyecto refuerza la desconfianza. Que el Ministerio de Justicia haya trabajado en esto durante dos años sin informar al público sugiere una falta de rendición de cuentas. La seguridad no puede lograrse a costa de los derechos fundamentales, y cualquier tecnología que aspire a predecir el comportamiento humano debe estar sujeta a un escrutinio riguroso y transparente.

Otro clavo más en el ataúd de la libertad individual.